维克多在2012年出版的《大数据时代》一书中曾预测:数据列入企业资产负债表只是时间问题。如今,伴随着新兴科技手段的融合创新,大数据已经应用到了我们生活中的方方面面,数据资产的概念已逐渐得到国内外企业的强烈认同。

但是,数据和企业资产可以直接划等号吗?实际情况是,没有经过系统管理和规划治理的数据集群,不仅很难为企业创造实际效益,而且还将带来权限混乱、计算能力下降、冗余存储计算、资源浪费等问题,使整个数据集群处于"亚健康"状态。

那么,是否有正本清源的应对方案呢?联通大数据有限公司技术部负责人李大中日前在2019大数据产业峰会-大数据前沿技术论坛进行分享,他以《联通大规模数据集群治理实践》为主题,分享运营商在数据资产管理方面的经验和对策。

应对大规模数据集群治理,联通大数据这么做

下文为李大中演讲内容整理:

联通大数据有限公司承担着联通大数据能力建设和对外服务运营职能,目前平台存储容量达100PB,Hadoop集群超过6000个节点,数据模型数量达2000余个。作为运营商在数据治理过程中,既要面对大数据量的实时处理需求,也必须从成本角度考虑集群算力配置、安全合规等方面的要求。大数据是一个高成本行业,集群算力成本是其中主要部分。

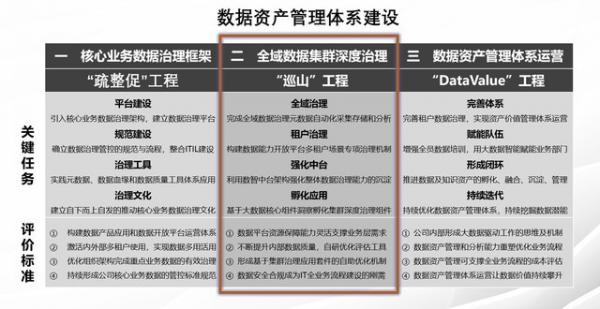

通过参考行业的治理经验,并结合公司业务和组织架构特点,我们总结出了一套适合公司业务发展的数据资产管理体系,也就是"疏整促+巡山+DataValue"数据资产管理体系:基于"疏整促"工程构建的全生命周期数据管控治理体系,基于"巡山"工程构建的大规模集群治理体系,基于"DataValue"工程实现对外数据价值经营,三大工程同步推进,形成数据治理+集群治理+数据价值的整体协同效应。

应对大规模数据集群治理,联通大数据这么做

在实际执行中,"巡山"工程作为切入点首先启动,效果也最为明显。在大规模集群计算环境处于亚健康的状态下,我们将治理工作分解为两阶段:首要任务是解决亚健康问题,即保障集群资源算力可用、确保集群稳定性、业务连续性;长期和更为重要任务是保持健康状态,即持续有效的监督数据治理工程的效果。

关于大规模数据集群治理的推进方法论,由于集群治理涉及到从采集、清洗到模型加工,从平台运维岗到产品开发岗,几乎涵盖了公司的整个技术线和产品线上百人工作内容,所以采用自上而下的顶层设计的方式是不现实的,我们采用的是自下而上、自发协同、精益推进式的数据集群治理文化。从发现问题点入手,由点带面找到原因、制定解决策略并建立相应的监督点,最终逐渐形成体系;通过某几个环节治理成果显性化,带动整个公司生产组织体系逐渐形成治理文化。

在治理过程中,针对我们遇到过的几个重要的点向大家介绍一下思路:

1.HDFS&YARN作业深度监控

针对小文件过多、文件量过大、耗资源大等情况,联通大数据通过自主研发一套统一元数据实时采集平台对Fsimage和EditLog进行反序列化解析,实时批量获取资源队列信息、文件目录、作业任务信息等内容,通过多维关联画像洞察疑似异常作业,推动作业优化和监控优化效果。最终集群文件数量从接近8000万下降为3000万,平均文件大小提升4倍。集群资源负载从每天几乎处于打满状态,下降为不到70%。每年节约固定资产投入上千万元。

2.RPC请求和关键服务预警

针对集群RPC经常出现请求延时过大,甚至达到秒级,导致集群处于停摆不可用状态,通过采集JMX指标、服务连接数、堆栈信息、GC等信息进行关联画像,并下钻洞察相关作业,精准定位待优化作业。优化后集群RPC请求延时大幅减少,下降为毫秒级别。

3.重复加工/冗余计算挖掘

针对数据重复加工、冗余计算等情况,估计大家的系统中或多或少都存在,这种情况直接导致资源被浪费。我们通过对HDFSJOBBINARYFILE分析,定位疑似冗余计算作业,这种方式同组织架构复杂度无关、不依赖上层业务输入,其核心思想就是通过提取出具有相同输入路径的作业,以目录维度视角挖掘疑似重复作业,优化后集群资源降低10%以上。

4.重构元数据管理、血缘分析应用

针对数据加工流向追溯、敏感数据难以有效跟踪等情况,通过对HIVE执行日志进行SOL解析,以及通过对SPARK作业输入输出目录画像,以无侵入方式建设企业级全域元数据平台,提供全域物理视图、业务视图、元数据变更跟踪监控、全域数据血缘关系图等核心功能,满足复杂的追溯需求以及故障范围评估。

谈及在治理过程中的感受,李大中指出:"大规模数据集群治理并非单人、单项目组能够完成的,而是需要以文化渗透的形式动员到公司生产开发组织体系中,采用自下而上自发协同,以OKR而非KPI的方式管理,在解决问题的过程中不断调整目标,从而建成持续优化的治理体制。当然,技术人员也要拥抱和吃透大数据开源技术,采用开创性的思维去解决